论文阅读_多类型实体的图对齐_CGMuAlign

读后感

文中的一个重要思想是:认为被对齐的图中的知识都是不完备的,所以在图间对齐时,主要对齐对些能齐上的,忽略那些对不上的;同时结构了自注意力模型,对不同关系分配不同权重。

多类型实体的图对齐 _CGMuAlign

英文题目:Collective Multi-type Entity Alignment Between Knowledge Graphs

中文题目:基于知识图的集合多类型实体对齐

论文地址:https://assets.amazon.science/ff/7a/b96282984a0fbe5e31a8fcf68d17/scipub-1202.pdf

领域:知识图谱,实体对齐

发表时间:2020 年

作者:Qi Zhu,伊利诺伊大学,亚马逊

出处:the web conference

被引量:17

代码和数据:https://github.com/GentleZhu/CG-MuAlign

阅读时间:2022.04.25

介绍

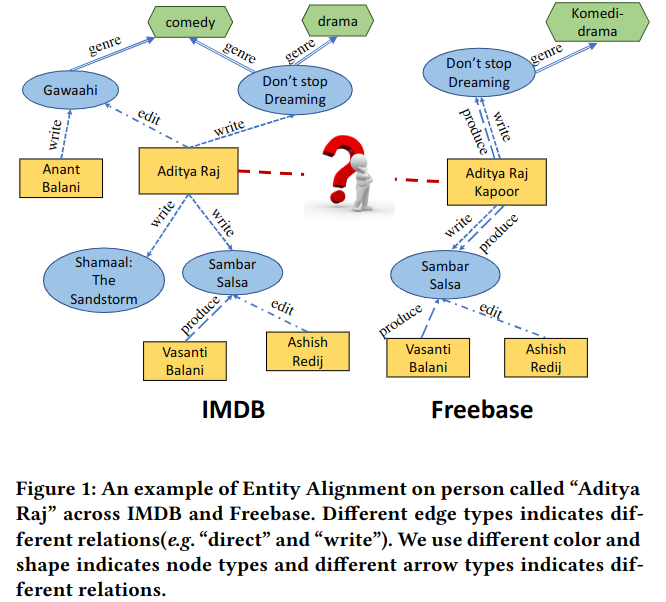

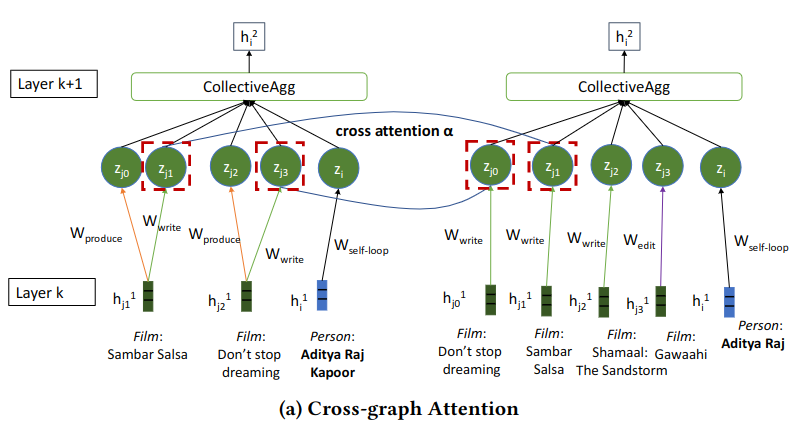

实体对齐的目标是识别不同图中的同一实体。不同的图在建构的时候由于目标不同,各有偏重。比如图 -1 中的左右两张图:

图中的 Aditya Raj 是同一实体,在左图中他即是作者也是编辑,而右图中它是作者和制作人,即:在不同图中实体有不同的类别。使用不同策略,对齐结果也不同。

实体对齐中常见的问题包括:使用图嵌入做对齐,忽略了丰富的属性信息,在传导模型中,加入新实体需要重新训练模型;模型常常在训练数据丰富时效果较好,而在稀疏和缺少的类型中效果较差(如有些数据没有标签)。

作者希望用 GNN 方法解决上述问题,GNN 方法通过逐步整合邻域,来实现归纳模型并计算之前没出现过的实体。测试后发现效果并不好,原因是之前方法认为节点完全一致的情况下才算对齐,两图的偏重不同就可能对不齐。比如图 -1 中 IMBD 包含编辑、导演、演员信息,而 Freebase 中包含导演和制作人信息。

所以文中提出了集成决策,设计了注意力机制在图间更关注实体的共同邻居作为正向证据。比如图 -1 中左图出现四部电影,右图出现两部电影,用之前的方法,不同邻居将产生不同节点嵌入,而文中方法给共同的邻居电影以更大权重。对于负例,使用自注意力机制,如两个同系列的电影可能有相同的作家、导演和演员,但年份和长度不同,对不同边给予不同权重。

主要贡献

- 提出基于 GNN 的 CG-MuAlign 框架,支持对齐不同类型。

- 结合了自注意力和图交叉注意力方法。

- 优化算法,使模型能在大规模数据集上使用。

- 在数据量大,标注量小的情况下,模型效果好。

算法

整体结构

定义图为:G = (V, E, T, R),求节点映射 φ: V → T 和边映射 ψ: E → R。注意这里的 T 指的不是三元组,而是节点类型。用 S 表示对齐种子(标注数据),只有少量数据被标注。

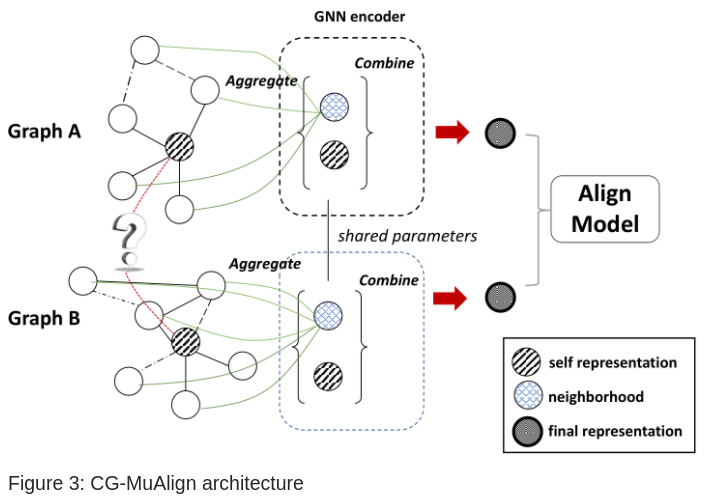

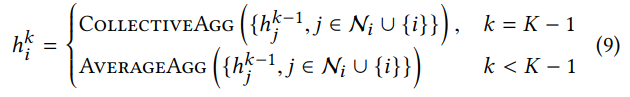

模型包含两个 GNN 编码器和一个对齐层。编码器从节点 v 得到 k 跳子图用于收集邻居信息:

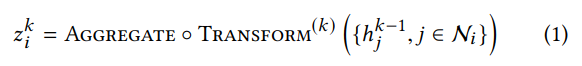

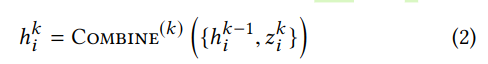

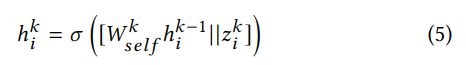

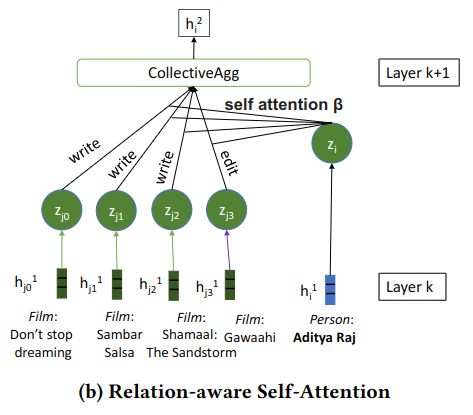

对于节点 i,利用它的邻居们 j 在前一层的表示,计算它的表示 z,再利用 z 和 i 节点本身在上一层的表示求它在本层的表示:

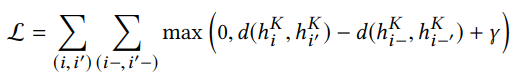

两个图的 GNN 结构和参数都相同,经过多层最终输出为两个 GNN 的隐藏层 h,计算距离损失函数:

这个公式之前文章中讲过,γ为加大正例和负例间的距离。d 是二范数的距离函数。模型结构如图 -3 所示:

集成 GNN

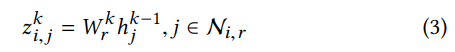

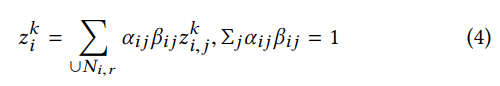

首先,根据边的类型对 i 的邻居编组 Ni,r,使用不同转换函数(参数矩阵 W),比如图 -1 左图作为作者有三个邻居,作为编辑有一个邻居,对每种邻居计算 z:

当图 -2 中一个人同时是作者和制作人时,上述方法可描述不同角色。

设节点级的注意力参数为 a,边级的注意力参数为 b,使用以下聚合方法,计算整体的 z:

然后计算第 k 层的隐藏层

其中||指串联,上述方法命名为 COLLECTIVEAGG。

每个 encoder 堆叠了多个层,k-1 层的输出作为 k 层的输入,第 0 层的输入是节点特征,允许不同类型特征有不同长度,所以第一层的 W 大小可能不同,后面层长度都一样。

节点级的交叉图注意力

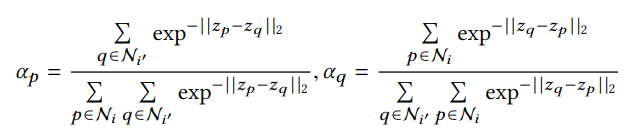

图结构差异主要是由知识图中的不完备性引起的。在 CG-MuAlign 中,对于在两图中都有的邻居给予更高的权重。设 p 与 q 是节点的邻居对 (p, q) ∈ Ni × Ni′,式 -4 中的 a 计算如下:

上式对 ap 和 aq 进行了归一化处理。a 越大说明 p 和 q 越像。如图 -2a 所示,算法给作为 writer 两项更高权重(红框),所以说图间注意力更偏重正例。

边级别的关系感知自注意力

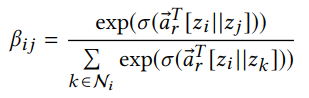

如果邻居只依赖交叉注意力聚合,则难以利用负面证据。比如在亚马逊音乐和维基百科中都有歌曲《Radioactive》,交叉注意力发现它们在图中的作者制作人等多数信息都相同,但演唱者不比,所以不是同一个实体,这说明对于歌曲,演唱者比作者制作人更重要。用 GAN 类似方法,计算边的注意力:

注意这里的 a 向量是注意力权重,而不是上面的 a(alpha)。

扩展

上述方法训练和应用运算量大,利用下面三种方法优化。

简化计算

基于开放世界假设,设 Gu 为完全知识图,而需要对齐的 G 和 G' 各有包含 Gu 的部分知识,设 K 为跳数。经过一系列推理(此处略过),说明随着 K 的增长,集合能力(上面公式中的集合方法)的期望呈几何衰减,服从长尾分布,所以只需要在最后一层使用集合方法以节约算力,其它均使用平均聚合方法:

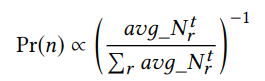

小批量训练和对邻居采样

传统图模型使用全局训练,在大数据集上无法应用。文中方法在训练数据的正样本对中采样,并构建 K 跳的子图,以节约算力。

另一个技巧是尽量对关系重要的邻居采样,以提升集合能力。比如一部电影一般是一个导演多个演员,所以导演携带更多信息。对不同关系的采样概率设置如下:

生成候选集

上述方法解析了训练算力问题,而预测时,可能需要面对数以百万计的实体。在生成候选集时,对于每个测试节点,使用几个强关键字 (如人名和出生日期) 来收集可能的匹配实体,并使用 CG-MuAlign 来预测候选对中的比对得分。

实验

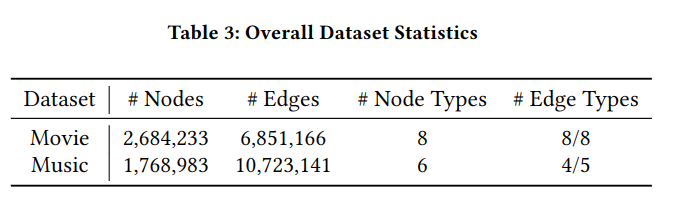

实验使用两个大数据集:电影数据和音乐数据集。

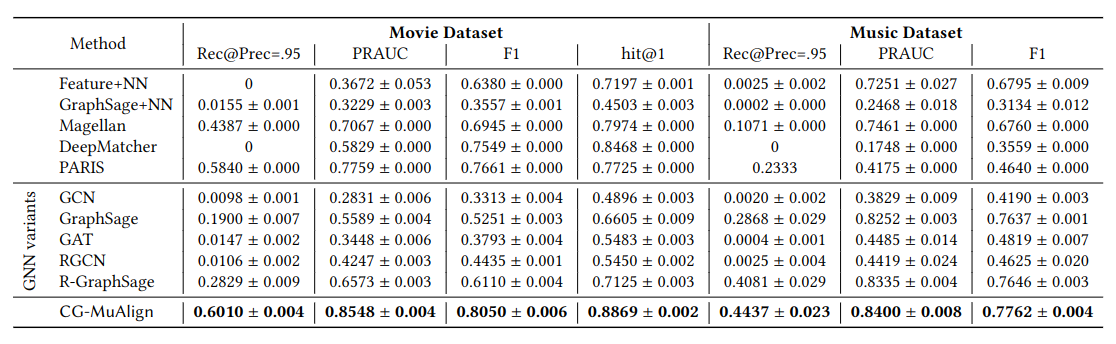

对比基线也都是非常流行的模型

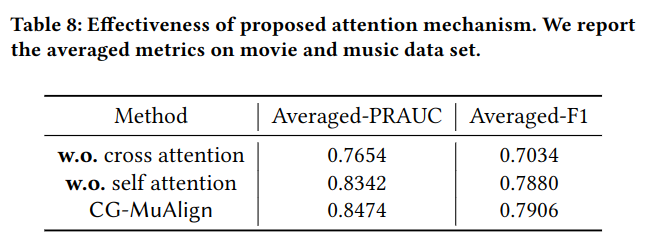

还对比了只使用 Self 或 Cross 的效果

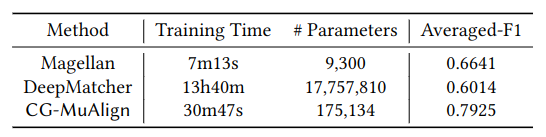

与之前深度学习模型相比运行时间短。