AI绘画_SD_搭建环境

一周之内体验了:Diffusion,CLIP,Segment Anything,Insightface,LoRA,ConnectNet 诸多算法的实际应用,全部是本地部署,0 花费。

1 选择 AI 绘画工具

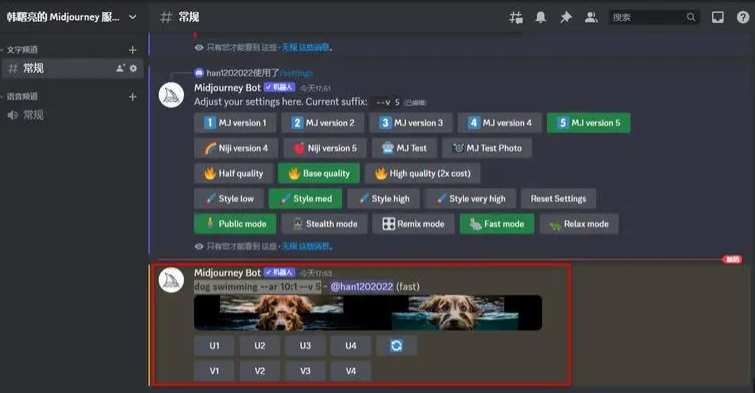

目前 Ai 绘画界有两大主流工具,Midjourney(简称 MJ)和 Stable Diffusion(称 SD)。

MJ 于 2022 年 3 月首次面世,已从 V3 模型发展至 V5 模型,SD 由 Stability AI 公司和非营利研究人员在 2022 年 8 月推出的,可在本地免费部署。

MJ 更适合新手入门,10 刀/月,30 刀/月,60 刀/月三档收费;低付费的图片是共享的,高付费服务能一对一出图;学习提示词门槛低;有一定的审核要求,敏感词比较多;少量设置后的画面看起来就很炫,但不太受控,自娱自乐还行,难以稳定输出。

SD 可以设置大量参数,下载海量模型,本地部署,提示词百无禁忌,针对实际工作中的目标,更需要 SD 来定制。它需要本地硬件支持,以及更高的学习成本。

如果只想玩一下,国内也有一些免费平台,浏览器端和手机端微信端都有,就是生成效果比较差。

从两个产品不同的生态圈就可以看出,开放的系统明显呈现出众人拾柴火焰高的趋势,从平台、插件、模型,到文档,工具都越做越好。另外,LoRA 技术让大家都可以自己训练自己的增补小模型,Civitai 圈的交流氛围,加入的人也越来越多。这就相当于 MJ 一个公司和所有人拼,又没有特别过人的核心技术。

艺术给人带来的体验和工作体验不太一样,大家更向往彼此的认同感,除了经济价值,工作本身就是工作的动力,这也成为一种巨大助推力。

2 搭建 SD 环境

2.1 介绍

Stable Diffusion(简称:SD)支持:通过描述生成图,或者改图,做自己的卡通头像,生成各种风格的画作,给线稿上色,修复相片,换脸,抠图 …… 点两下鼠标,几秒就能生成一张作品。在自家机器上搭建一个 SD 环境,不用花钱,不用上网也能使用。

不过还是有点门槛,比如:

- 安装时需要 “科学”连接下载网站(否则无法随心选择海量模型)

- 英文尚可,能看懂界面和简单说明(用翻译软件也不是不行)

- 会一点 Python 如遇问题自己能解决(也不一定会遇到问题)

- 有带 6G 以上显存的 GPU 的机器(没有 GPU 会很慢,但也能用)

- 至少 20G 的磁盘剩余空间(这个必须有,建议 50G,最好是 SSD,否则加载模型特别慢)

本教程中我使用了 Ubuntu + Docker 方式安装,这是目前我能找到最简单的方法,几乎只需要输入一个命令,即可运行基本功能;当然前提是事先安装了 Ubuntu 系统 Docker 环境以及 GPU 驱动。

这仅仅是运行环境,后面涉及各种模型的组合,调参,插件,了解工具周边生态,与其它工具联合使用;还有审美,光影的感觉,对受众内心的揣摩…… 总之,当一个 AI 画手也不是件容易的事。

2.2 基础环境

操作系统: Ubuntu 22.04

显卡: NVIDIA GTX 1080 Ti 11GB 显存

2.3 安装方法

SD github 项目中推荐直接在系统中安装环境。我则更喜欢把 Python、git、conda 一系列工具都打包在内的 docker 安装方式,这避免了与机器上安装的其它工具的冲突。

siutin/stable-diffusion-webui-docker 是目前下载量最大的 Stable Diffusion 镜像,几乎和 Stable Diffusion github 版本同步更新,相比几个同类镜像,它的大小和易用性也是最好的。

2.3.1 CPU 版本

1 | $ docker run -it --name sdw --network host \ |

下载后安装模型即可使用。

参数:--no-half 由于我这边一直报错,所以设置了该参数。

参数:--listen 设置后可使用其 ip 地址访问服务,否则只允许本机用 127.0.0.1 访问,服务默认端口为 7860。

参数:--enable-insecure-extension-access 允许使用插件

2.3.2 GPU 版本

1 | $ nvidia-docker run -it --name sdw --gpus all --network host \ |

2.3.3 下载模型

我下载的第一个模型是:

https://huggingface.co/runwayml/stable-diffusion-v1-5/resolve/main/v1-5-pruned-emaonly.safetensors

可用于生成真实场景,修图,换图等,大小为 4.2G,下载后放入 stable-diffusion-webui/models/Stable-diffusion/ 目录。

2.3.4 使用

如果上述程序不报错,在浏览器打开 127.0.0.1:7860,即可看到 gradio 生成的界面。

2.3.5 注意事项

- 请将模型、输出、扩展名映射到 docker 以外的目录,以保证正常保存数据。

- 以 bash 方式进入镜像后,使用命令运行 webui.sh 工具,这样可以在重启时一定程度保留现场,也较方便调试。

- 安装时,我的 CPU 版正常运行了,GPU 版老是报错,于是升级了宿主机的 GPU 驱动(从 470 升到 535,nvidia-driver-535, nvidia-utils-535 两个包),重启后一切正常

- CPU 版本工具 3 分钟生成一张图,GPU 版本 7 秒生成一张图,是完全不同的体验。

- 插件和模型数据未必都下载到 models 目录下,所以我后来做了 docker commit,以保存现场。

2.4 调试命令

- 查看 torch 可否支持当前 GPU

1 | python -c "import torch; print(torch.cuda.is_available())" |

- 查看当前 GPU 硬件

1 | lspci |grep VGA |

venv

venv 是 Python 的虚拟环境工具,以支持多个 Python 环境并存。它是 Python 3.3 版本后标准库中的一个模块。stable diffusion 使用了 venv 将环境搭建在 /app/stable-diffusion-webui/venv/下,自行调试需设置 venv:

1 | python -m venv venv # 设置环境 |

2.5 更新到最近版本

1 | docker pull siutin/stable-diffusion-webui-docker:latest-cuda |

2.6 问题及解决

2.6.1 问题一

- 问题:右上提示报错:Error Expecting value: line 1 column 1 (char 0)

- 解决方法:去除 HTTPS_PROXY 与 HTTP_PROXY 的设置即可

- 重要重要!!!

3 源码

源码并不多,去掉.git 目录,只有 4M 左右。当前版本共 160 个 python 文件,主要包含:内置函数 extensions-builtin,支持工具 scripts,以及主功能模块 modules。整体 python 代码量在 3W-4W 行左右。界面基于 gradio 框架开发。