论文阅读_思维链_EoT_思想交流

1 | 英文名称: Exchange-of-Thought: Enhancing Large Language Model Capabilities through Cross-Model Communication |

读后感

文章提出框架 EoT,可视为 CoT 框架的进化版本。它利用多个模型提升模型的推理能力,其主要工作在于设计和实现跨模型通信,包括:模型之间通信,通信终止条件,最小化错误推理对结果的影响。该模型具有整合外部多方观点的能力,可通过引入丰富的知识来提升解决问题的能力。

摘要

目标:提出一种新的框架 Exchange-of-Thought (EoT),通过跨模型通信来增强大型语言模型(LLMs)在复杂推理任务中的性能。

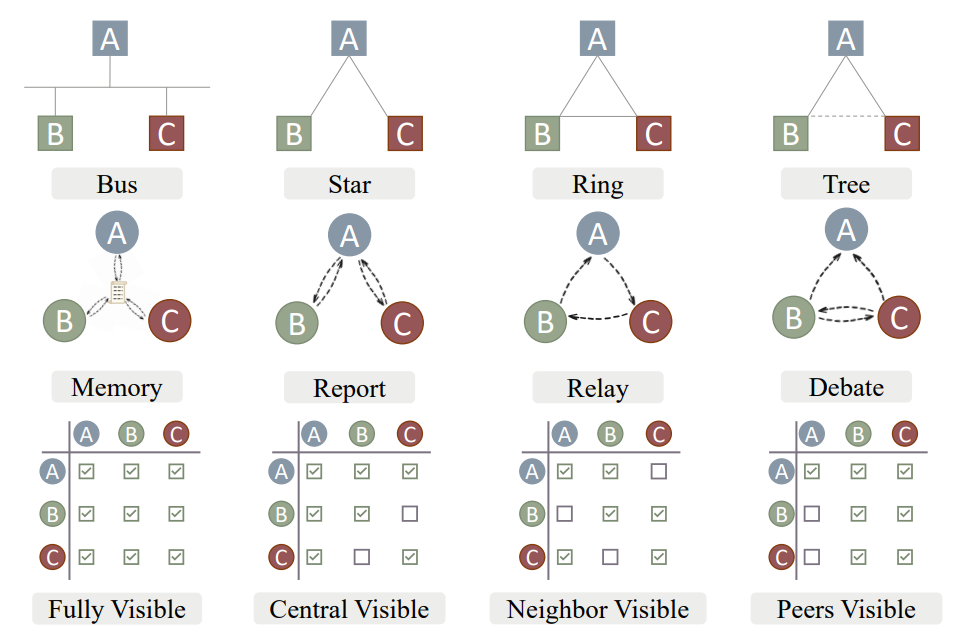

方法:通过集成四种独特的通信范式(Memory、Report、Relay 和 Debate),实现跨模型通信,并在通信过程中实现了可靠的置信度评估机制。

结论:EoT 在各种复杂推理任务中显著超越了已有的基准模型,提供了外部洞察力对提升 LLM 性能的价值。此外,EoT 以一种高效且协作的方式实现了优越结果。

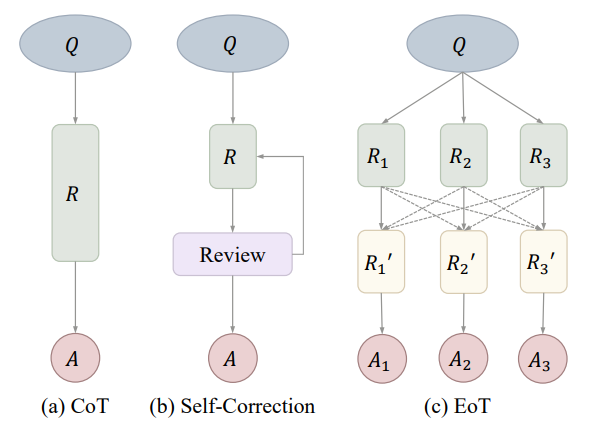

图 1:CoT、自我纠正和 EoT 的比较。CoT 和自我纠正都依赖于模型本身生成和改进输出的能力,缺乏外部见解。EoT 通过将其他模型的思考作为外部见解,增强了模型的推理能力。

图 3:通信范式与网络拓扑之间的对应关系。顶部一行展示了四种网络拓扑结构。第二行将这些网络结构与相应的通信范式相关联。底部一行分析了每种范式所关联的通信量。水平轴表示节点可以接收的信息,垂直轴表示节点可以发送的信息。

All articles in this blog are licensed under CC BY-NC-SA 4.0 unless stating additionally.