论文阅读_中文NLP精减模型ELECTRA

- 介绍:ELECTRA 由 Manning 联合谷歌发布,后来哈工大讯飞联合实验室训练了相应的中文模型。精减后的模型效果和 BERT 差不太多,而模型大小只有 BERT 的 1/10,ELECTRA-small 只有 46M。

- 代码&模型下载&详细说明:https://github.com/ymcui/Chinese-ELECTRA

- 使用:LTP 使用它为基础模型。

- 原理:使用生成对抗网络训练自然语言模型,时间短,参数少。模型分为两部分:生成器和判别器,生成实现 MLM,判别器用于识别每一个单词是否为模型生成。

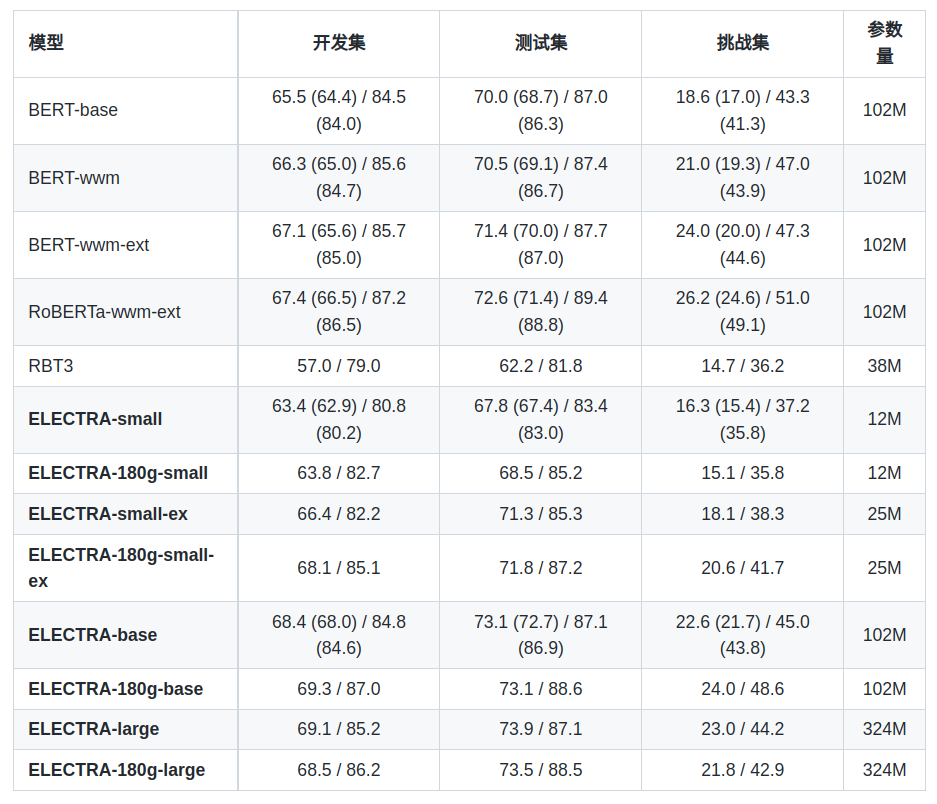

- 效果:以中文阅读理解为例,其效果对比如下,其它实验详见 github

All articles in this blog are licensed under CC BY-NC-SA 4.0 unless stating additionally.