论文阅读_扩散模型_LDM

1 | 英文名称: High-Resolution Image Synthesis with Latent Diffusion Models |

1 读后感

Latent Diffusion Models(LDMs)基于潜空间的扩散模型,是目前主流的基础模型,Stable diffusion 就是基于 LDMs 原理工作的。之前的扩散模型运算都在像素层面,优化通常会消耗数百个 GPU 天,且评估和推理成本也很高。LDMs 大量自编码器的运算基于潜空间数据,降低了计算复杂度,从而大幅节省了算力,并保持了图像质量和灵活度,它让更多人可以训练模型。其应用场景包含有条件(根据文本或图像生成图像)和无条件(去噪/着色/根据涂鸦合成)的图像生成。

研究背景和动机

扩散模型是由逐层去噪的自动编码器构建的,基于似然的模型。这种模型倾向于花费过多的容量和资源对难以察觉的细节进行建模,尽管使用了重新加权的变分目标,但在 RGB 图像的高维空间中训练和生成仍需要大量计算。

LDMs 学习可以分为两个阶段:首先找到一个感知上等效但计算上更合适的空间(感知压缩);然后,在其上训练扩散模型(语义压缩)。另外,本中还通过设计架构,分离了自动编码和具体的任务,使得同一编码器可用于多个任务。

论文贡献如下:

- 优化压缩,支持更忠实和详细的重建效果,有效构建高分辨率图像。

- 在多种任务中,显著降低了推理成本。

- 不需要对重建和生成能力进行微妙的加权,几乎不需要对潜在空间进行正则化。

- 模型可以卷积方式使用并渲染约 1024x1024 像素的大而一致的图像。

- 设计了基于交叉注意力的调节机制,实现了多模式训练模型(一个模型支持多个功能)。

- 在 github 上开源了算法。

方法

明确分离压缩阶段和生成阶段有以下优势:(1) 脱离高维空间,在低维空间中的扩散模型更高效;(2) 继承了 UNet 架构的归纳偏差,这对具有空间结构(上下左右的相关性)的数据特别有效;(3) 获得通用压缩模型,其潜在空间可用于训练多种生成模型,也可用于其他下游应用。

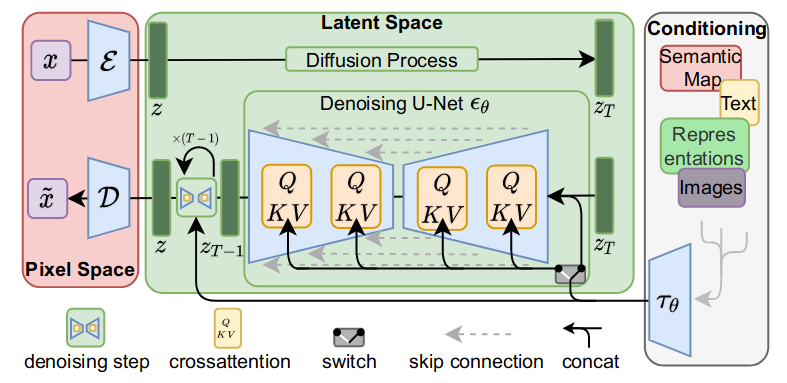

主逻辑分成三部分,第一部分是像素空间与潜空间之间的转换,即感知图像压缩(粉色);第二部分是在潜空间操作的扩散模型(绿色);第三部分是用文本描述或其它图片作为条件,控制图像生成(白色)。

感知图像压缩

感知压缩模型由一个通过感知损失和基于 patch 的对抗目标相结合的自编码器组成。

给定 RGB 空间中的图像 x ∈ RH×W ×3,编码器 E 将 x 编码为潜在表示 z = E(x),解码器 D 从潜在表示重建图像,给出 ̃ x = D(z) = D(E(x)),其中 z ∈ Rh×w×c。编码器按因子 f = H/h = W/w 对图像进行下采样(后面实验发现,下采样在 4,8,16 时效果最好)。

潜空间扩散模型

扩散模型

扩散模型原理比较复杂,详见 论文阅读_扩散模型_DDPM,这里只做简单介绍:

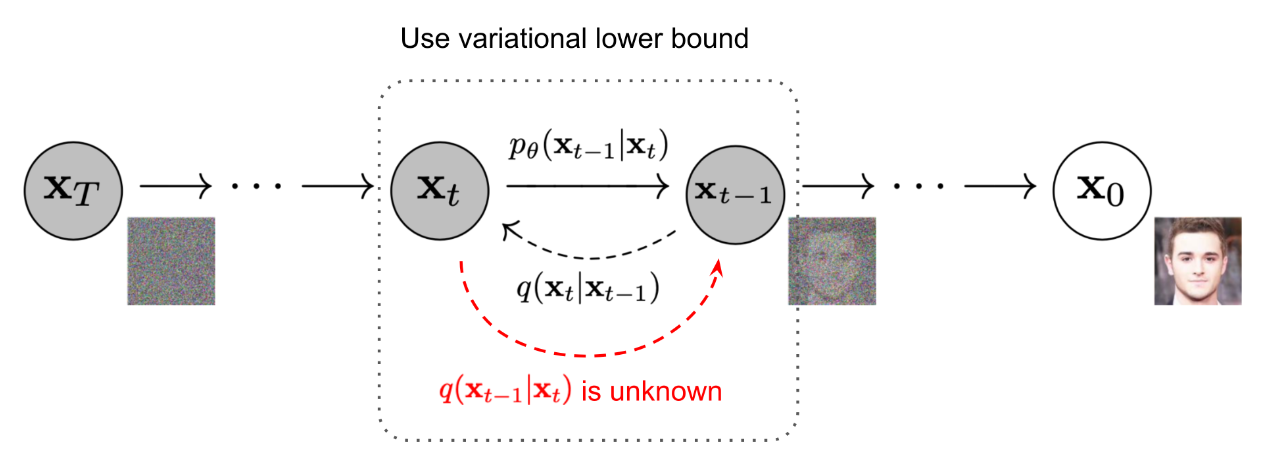

- 有一张图 x0,分多步,每步向图里加入少量噪声,图将变得越来越模糊,最后变成了一张全是噪声的图 xT,将加噪操作设为 q。

- 在中间过程第 t 步,有可能从第 t 步还原出第 t-1 步的图像,以此类推,一步一步往上倒,理论上,就能从最后一步 xT 还原出原图 x0。将去噪操作设为 p。

- 所以建模的目标是找到从 t 步还原第 t-1 步的方法,也就是对 p 建模。

经过简化,最终扩散模型的目标函数是:

这里考虑第 t 步,xt 是第 t 步的加噪图像,经过训练来预测其输入 xt 的去噪变体 ε,目标是让实际值和模型预测值尽量一致,通过训练给模型调参。

潜空间的扩散模型

将作用于像素级的扩散模型转换为作为于压缩低频空间(潜空间)的扩散模型。与高维像素空间相比,该空间更适合基于似然的生成模型,因为它可以专注于数据的重要语义;且在较低维度进行训练更为高效。

公式变为:

文中模型的主干 εθ 通过时间条件 UNet 实现。由于前向过程是固定的,在训练期间可以通过 E 有效地获得 zt,并且只需通过 D 即可将来自 p(z) 的样本解码到图像空间。

条件机制

扩散模型原则上能够对 p(z|y) 形式的条件分布进行建模。它通过条件去噪自动编码器 εθ(zt, t, y) 来实现,通过输入条件 y(通过文本生成图像,通过图像生成图像)控制合成过程。

具体方法是通过交叉力注意机制增强其底层 UNet 主干网,Attention(Q, K, V),

其中 y 是条件,φi(zt) 是 UNet 的中间表示,的 WQ, WK, WV 是可学习的投影矩阵。

通过图像条件对数据来训练模型。其中 τθ 和 εθ 联合优化。这种调节机制非常灵活,因为 τθ 可以由特定领域的专家网络进行参数化,τθ处理后条件入引绿色块,通过交叉注意力,作用于主干网络εθ,影响图像的生成。有效地解耦了条件模块和图像模块,即使后面加入其它条件,也不需要考虑修改绿色的主干网。