开源项目_代码生成项目介绍

1 CodeGeeX 系列

1.1 CodeGeeX

- 项目地址:https://github.com/THUDM/CodeGeeX 7.6k Star

- 主要由 Python 编写

- 深度学习框架是 Mindspore

- 代码约 2.5W 行

- 有 Dockerfile,可在本地搭建环境

- 模型大小为 150 亿参数

- 使用 850 B token 训练

- 相对早期的代码生成模型,开放全部代码

- 论文 论文阅读_代码生成模型_CodeGeeX

- 用法 编程助手_CodeGeeX

1.2 CodeGeeX2

- 项目地址:https://github.com/THUDM/CodeGeeX2 6.5k Stat

- 主要由 Python 编写

- 推理部分开源,通过 pytorch 调用

- 代码约 1900 行,主要为示例和评测

- 基于 ChatGLM2 架构,模型部分也没开源,只开源推理部分

- 模型 60 亿参数,6G 显存即可运行

- 使用 600 B 代码数据预训练

- 支持最大 8192 序列长度

1.3 其它资源

- 官网:https://codegeex.cn/

1.4 讨论

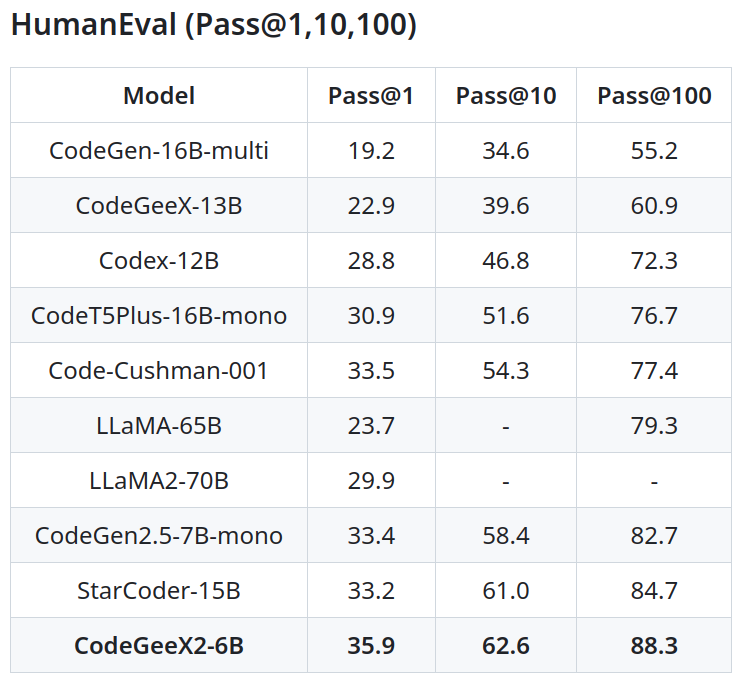

CodeGeeX 与 CodeGeeX2 效果对比如下:

2 ChatGLM 系列

2.1 ChatGLM2

- 项目地址:https://github.com/THUDM/ChatGLM2-6B 15.2k Star

- 代码:用 Python 实现,代码量约 1200

- 基于 Pytorch 框架

- 模型可在 huggingface 下载,支持本地部署

- 提供 ChatGLM2-6B 模型基于 P-Tuning v2 的微调功能

2.2 ChatGLM3

- 项目地址:https://github.com/THUDM/ChatGLM3 10.1k Star

- 代码:用 Python 实现,代码量约 3200

- 基于 Pytorch 框架

- 模型可在 huggingface 下载,支持本地部署

- 支持微调,微调说明:https://github.com/THUDM/ChatGLM3/tree/main/finetune_demo

- 官网说明:https://zhipu-ai.feishu.cn/wiki/WvQbwIJ9tiPAxGk8ywDck6yfnof

2.3 讨论

- ChatGLM 2 之后模型框架就不再开源,但可以通过打印模型结构看一下,传说 GLM 架构变为 llama 架构

3 code llama 系列

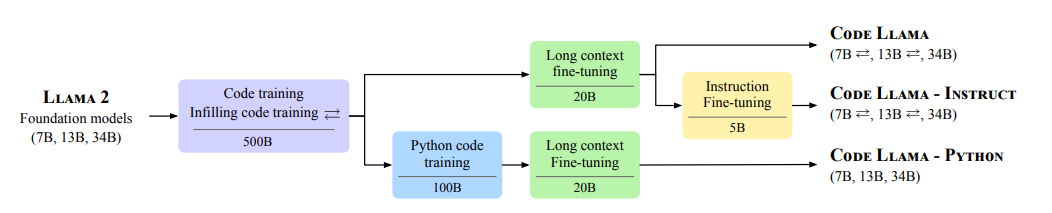

3.1 codellama

- 项目地址:https://github.com/facebookresearch/codellama 13.7k Star

- 代码非常之简单,只有 929 行

- 基于 Pytorch 框架,模型在 meta 网站下载

- 相关论文:https://arxiv.org/abs/2308.12950 论文阅读_代码生成模型_CodeLlama

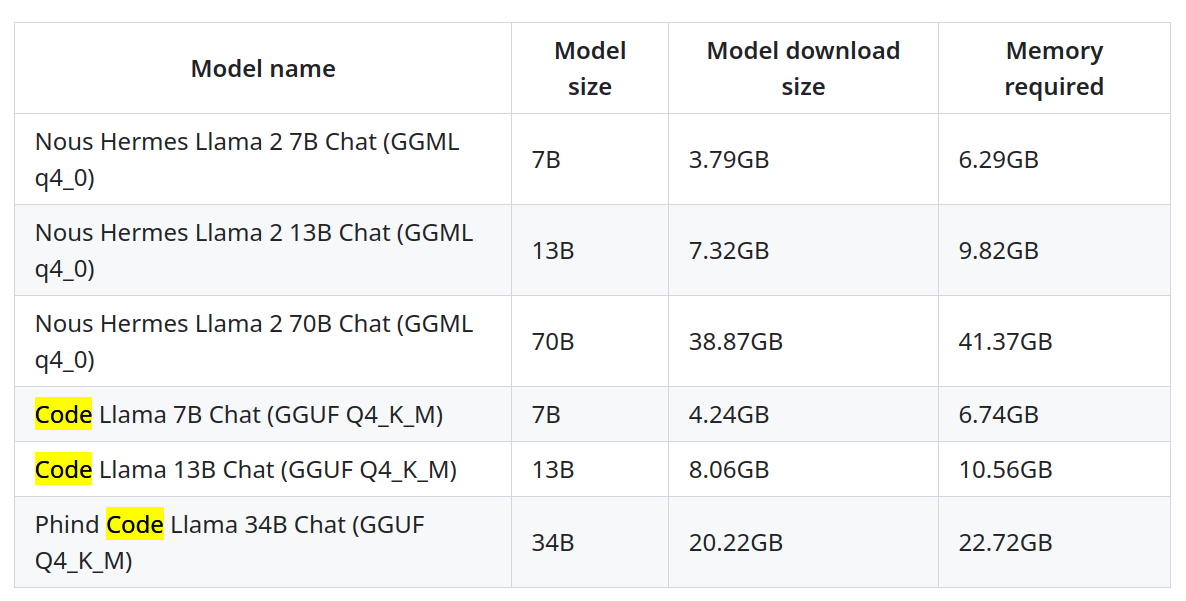

3.2 llama-gpt

- 项目地址:https://github.com/getumbrel/llama-gpt 10.1k Star

- 支持 code llama model

4 参考

All articles in this blog are licensed under CC BY-NC-SA 4.0 unless stating additionally.